Wielu z nas zastanawia się, skąd aplikacja wie, że dany produkt – film, program, zespół muzyczny – trafi w nasze gusta. Jest to możliwe właśnie dzięki AI, która przeanalizowała nasze dotychczasowe zachowania i wyciągnęła poprawne wnioski. Sztuczna inteligencja to zestaw narzędzi, które umożliwiają maszynom podejmowanie samodzielnych decyzji. W popkulturze utarła się wizja AI jako zagrożenia dla człowieka. W rzeczywistości sztuczna inteligencja nie ma na celu zastąpienia ludzi. Wręcz przeciwnie, ma nas wspomagać w szybkim rozwiązywaniu skomplikowanych zagadnień. Również tych dotyczących pogody i klimatu.

AUTOR: Michał Marosz, IMGW-PIB, Zakład Badań Morskich

Sztuczna inteligencja (ang. artificial intelligence – AI) jest zbiorem metod i algorytmów, które pozwalają komputerom w pewnym stopniu naśladować ludzką inteligencję. Istotną funkcją AI jest możliwość doskonalenia się w procesie uczenia. Każdy z nas ma do czynienia z algorytmami sztucznej inteligencji w codziennych sytuacjach. Wirtualni asystenci, np. Asystent Google czy Siri, jak również algorytmy umożliwiające rozpoznawanie twarzy i podpowiadające nam, co wybrać, to najbardziej oczywiste przykłady. Sztuczna inteligencja szybko i efektywnie przetwarza znaczne ilości danych, co pozwala jej na identyfikację i kwantyfikację wzorców, które są w danych „ukryte”, i przygotowanie trafnej odpowiedzi na poprawnie skonstruowane pytania.

Sztuczna inteligencja skuteczniejsza w prognozowaniu zjawisk atmosferycznych?

Gwałtowny rozwój AI w ciągu ostatniej dekady, w tym zwłaszcza uczenia głębokiego, potwierdził możliwości stosowania tego typu narzędzi w zadaniach opartych na rozpoznawaniu nieliniowych wzorców. W naukach atmosferycznych występuje szereg problemów, które wymagają takiego podejścia – przewidywanie pogody to w zasadzie złożona prognoza nieliniowych procesów w trzech wymiarach. Zrodziło się zatem pytanie, czy metody AI mogą zostać wykorzystane w modelach prognostycznych.

Możliwość prognozowania zjawisk meteorologicznych w czasie rzeczywistym jest jednym z podstawowych zadań stawianych współcześnie przed służbami hydrologiczno-meteorologicznymi.

Zwłaszcza w kontekście zdarzeń ekstremalnych: burz, opadów gradu, powodzi błyskawicznych (flash floods) czy fal upałów. Fizyka tych zjawisk jest znana i opisywana z pewnymi uproszczeniami przez modele dynamiczne stosowane w prognozowaniu meteorologicznym. Podkreślić jednak należy, że mają one ograniczenia, wynikające z charakterystyki stosowanych schematów parametryzacji procesów w skali podgridowej oraz dostępności zasobów obliczeniowych.

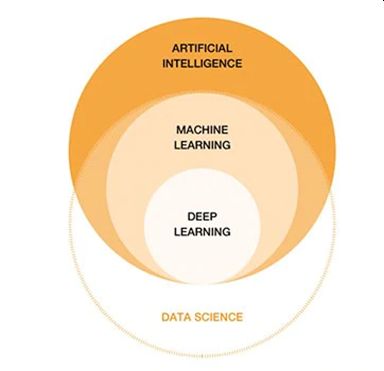

Struktura sztucznej inteligencji (AI) względem data science i stosowanych metod: uczenia maszynowego (ang. machine learning) oraz uczenia głębokiego (ang. deep learning)

Źródło: Oracle

Uczenie maszynowe (ang. machine learning) jest częścią sztucznej inteligencji lub inteligencji obliczeniowej. Zajmuje się algorytmami ukierunkowanymi na analizę danych i uczenie się, a następnie wykorzystywanie zdobytej wiedzy np. w celach prognostycznych. Są cztery główne rodzaje uczenia maszynowego: nadzorowane, półnadzorowane, nienadzorowane i ze wzmocnieniem.

Uczenie głębokie (ang. deep learning) to podzbiór uczenia maszynowego, który zajmuje się klasyfikowaniem, rozpoznawaniem, wykrywaniem i opisywaniem danych za pomocą sztucznych sieci neuronowych z wieloma nieliniowymi warstwami ukrytymi, co umożliwia przetwarzanie olbrzymiej ilości informacji, a poprzez to identyfikację wzorców i predykcję na poziomie niedostępnych dla tradycyjnych metod uczenia maszynowego.

Sztuczna inteligencja – prawdziwa prognoza

Procedura przygotowywania prognozy pogody jest skomplikowana. To truizm, jednak w rzeczywistości niewiele osób zdaje sobie sprawę z realnego poziomu tego skomplikowania.

Ilość danych, które muszą zostać przetworzone, jest olbrzymia: dziesiątki tysięcy punktów obserwacji naziemnych administrowanych przez krajowe służby hydrologiczno-meteorologiczne, aerosondaże, zdjęcia satelitarne, boje rozmieszczone na oceanach. Sama procedura asymilacji danych z różnych źródeł, połączona z kontrolą jakości, a następnie zaimplementowanie ich do modeli numerycznych stanowi ogromne wyzwanie. Jeżeli uzmysłowimy sobie, że w przypadku prognozy gwałtownych zjawisk ekstremalnych powinno to nastąpić niemalże w czasie rzeczywistym, to narzędzia klasy AI stają się potencjalnie nieodzownym składnikiem arsenału służb hydrologiczno-meteorologicznych na świecie (np. NOAA już wykorzystuje sztuczną inteligencję). Współcześnie tzw. nowcasting (prognozy krótkoterminowe z horyzontem czasowym do 6 godzin) w dużej mierze opiera się na wykorzystaniu narzędzi modelowania wywodzących się z metod modelowania statystycznego, w tym AI.

Maszynowe czy głębokie?

Do tej pory uczenie maszynowe (ML) było zazwyczaj wykorzystywane w postprocesingu wyników z modeli numerycznych. W ostatnich latach pojawiły się pierwsze modele hybrydowe, stosowane np. w parametryzacji zachmurzenia lub promieniowania. Podstawowym założeniem tych prób było zastępowanie komponentów modeli numerycznych (skomplikowanych obliczeniowo lub cechujących się znaczną niepewnością) algorytmami uczenia maszynowego przy pozostawieniu innych składowych modelu bez zmian. Tego typu podejście ma sporo wad – m.in. nie do końca rozpoznane są interakcje między komponentami numerycznymi a ML. Innym problemem jest implementacja ML w modelach napisanych przeważnie w języku Fortran.

Uczenie głębokie (DL), wykorzystujące sieci neuronowe z wieloma warstwami ukrytymi, bazuje na zdolności sieci neuronowych do zautomatyzowanego identyfikowania wzorców w przestrzeniach wielowymiarowych opisywanych przez dane. Zakres zastosowań DL jest bardzo szeroki. W przeglądowym artykule „WeatherBench: A benchmark dataset for data-driven weather forecasting” [1] autorzy wskazują na możliwość wykorzystania uczenia głębokiego w problemach prognozowania pogody.

Potencjał

Wśród zagadnień AI wykorzystywanych w meteorologii i klimatologii można zwrócić uwagę na dwa charakterystyczne obszary: klasyfikację oraz predykcję.

Większość analizowanych procesów geofizycznych to procesy nieliniowe. Siłą rzeczy możliwość ich poprawnej (w kontekście praktycznego wykorzystania) klasyfikacji umyka najprostszym stosowanym metodom, które nie pozwalają na efektywną analizę tego typu zjawisk. Za przykład może tutaj posłużyć klasyfikacja procesów cyrkulacyjnych, w znacznej mierze odpowiedzialnych za kształtowanie warunków pogodowych w umiarkowanych szerokościach geograficznych, a w dłuższym horyzoncie czasowym także klimatycznych cech analizowanego obszaru.

Klimatologia synoptyczna, zajmująca się kwantyfikowaniem powiązań między formami cyrkulacji atmosfery (zazwyczaj w skali makrosynoptycznej) a warunkami środowiskowymi, bazowała zazwyczaj na określonej typologii. W najogólniejszym zarysie podejścia były dwa: typologie manualne (np. Osuchowskiej-Klein, Grosswetterlagen, makroformy cyrkulacji Wangenheima-Girsa) lub typologie obiektywne, obecnie częściej określane jako computer assisted (np. wykorzystywana w IMGW-PIB typologia Lityńskiego czy też typologia Ustrnula).

W każdym z tych schematów postępowania – nawet tych jeszcze kilka lat temu nazywanych obiektywnymi – na pewnym etapie badacz zmuszony jest do podjęcia arbitralnych decyzji np. dotyczących liczby wydzielonych typów. Wszystko to powoduje, że analizowany obraz jest w znacznym stopniu zgeneralizowany, co nie pozwala w pełni prawidłowo odzwierciedlić sytuacji synoptycznej odpowiedzialnej np. za wystąpienie zjawiska ekstremalnego. Problemy „klasycznych” algorytmów klasyfikacyjnych można uznać za w znacznym stopniu rozwiązane przy wykorzystaniu narzędzi z katalogu metod AI.

W przypadku zagadnień klasyfikacyjnych wykorzystanie sztucznych sieci neuronowych, a konkretnie algorytmu Kohonena, pozwala na zdefiniowanie wzorców pola geofizycznego – w odniesieniu do analiz cyrkulacyjnych najczęściej jest to SLP lub wysokość określonej powierzchni izobarycznej. Wzorce te klasyfikowane są w tzw. mapę topologiczną, na której bliżej siebie położone są typy cyrkulacji podobne do siebie. Problem ustalenia optymalnej liczby wzorców nadal istnieje, jednakże zastosowanie obiektywnych miar jakości sieci pozwala na świadomy, a nie podyktowany przeczuciem badacza lub znaczną liczbą testów w trybie prób i błędów, wybór optymalnej liczby typów. Tego typu analizy często stosowane były w badaniach ekstremalnych opadów w Japonii [2] i Afryce Południowej [3], anomalnych charakterystyk pola temperatury w Chinach [4], jak również w regionie atlantycko-europejskim, gdzie np. analizowano zmienność cech cyrkulacji atmosferycznej w skali całego XX wieku. [5]

Czernecki z zespołem [6] wykorzystali możliwości algorytmu lasu losowego (ang. random forest) w modelowaniu wystąpienia dużego gradu (>2 cm) w Polsce. Analiza obejmowała wykorzystanie kilkudziesięciu parametrów opisujących stan warstwy atmosfery i pozwoliła nie tylko na opracowanie zadowalających modeli, ale również na wskazanie potencjalnych zmiennych prognostycznych, mogących polepszyć jakość prognoz nowcastingowych wystąpienia dużego gradu.

Czernecki z zespołem [6] wykorzystali możliwości algorytmu lasu losowego (ang. random forest) w modelowaniu wystąpienia dużego gradu (>2 cm) w Polsce.

Analiza obejmowała wykorzystanie kilkudziesięciu parametrów opisujących stan warstwy atmosfery i pozwoliła nie tylko na opracowanie zadowalających modeli, ale również na wskazanie potencjalnych zmiennych prognostycznych, mogących polepszyć jakość prognoz nowcastingowych wystąpienia dużego gradu.

F. Ian Battaglia | Unsplash

Rasp i inni [7] wykorzystali AI do średnioterminowych prognoz i przeprowadzili próbę dla horyzontu czasowego 3-5 dni. Autorzy podkreślają, że sprawdzalność współczesnych numerycznych modeli prognostycznych (NWP – numerical weather prediction) jest dobra, ale wymaga znacznych zasobów obliczeniowych. Ma to szczególnie duże znaczenie przy sporządzaniu probabilistycznych prognoz wiązkowych, w których modele wielokrotnie (kilkadziesiąt razy) generują przebieg przyszłych warunków meteorologicznych. Modele wykorzystujące uczenie maszynowe mogą okazać się o wiele mniej wymagające w tym zakresie. Pozwoli to na generowanie liczniejszych wiązek prognoz i lepszą estymację parametrów, co ma szczególne znaczenie w przypadku zdarzeń ekstremalnych.

Wykorzystanie narzędzi z zakresu AI możliwe jest również w modelowaniu stężeń zanieczyszczeń, gdy zestaw czynników mających realny wpływ na pole imisji jest duży, a wykorzystanie klasycznych modeli dyspersji – niemożliwe lub utrudnione. Sztuczne sieci neuronowe lub algorytmy typu drzewo losowe pozwalają na kwantyfikowanie nieliniowych powiązań między zmiennymi wyjaśniającymi a stężeniami analizowanych zanieczyszczeń. Przykładem mogą być tutaj badania prowadzone przez zespół Jędruszkiewicz, Czerneckiego i Marosza [8]. Autorzy analizowali możliwości zastosowania różnych algorytmów uczenia maszynowego w prognozach stężeń pyłu zawieszonego w wybranych aglomeracjach Polski (Kraków, Łódź, Trójmiasto, Poznań). Nidzgórska-Lencewicz wykorzystała sztuczne sieci neuronowe w analizie stężeń pyłu zawieszonego w aglomeracji trójmiejskiej [9]. W aglomeracji górnośląskiej IMGW-PIB już kilkanaście lat temu wdrożył operacyjnie system prognoz stężeń zanieczyszczeń oparty na sztucznych sieciach neuronowych [10].

AI będzie nas wspierać

Jak widać, spektrum potencjalnych zastosowań AI w analizach i operacyjnej pracy służb hydrologiczno-meteorologicznych jest szerokie i można zaryzykować hipotezę, że wraz z rozwojem tych metod będzie się tylko zwiększać.

Niemniej podnoszone są wątpliwości odnośnie do interpretowalności algorytmów AI. Większość z nich to tzw. czarne skrzynki. W ostatnim okresie prowadzone są zaawansowane badania mające na celu odczarować AI w tym aspekcie. Innym podstawowym pytaniem jest to, czy modele DL – lub ogólnie AI – są w stanie nauczyć się fizyki atmosfery. Pytanie to pozostaje otwarte, chociaż, jak widać, pierwsze rezultaty są obiecujące.

W moim przekonaniu prognozowanie warunków pogodowych będzie w najbliższych latach nadal opierać się na modelach dynamicznych, których jakość (sprawdzalność, rozdzielczość przestrzenna i czasowa, udoskonalone schematy parametryzacji) jest stale rozwijana. Z całą stanowczością można jednak stwierdzić, że metody AI będą mieć coraz większy udział w palecie narzędzi wykorzystywanych w naukach o Ziemi, a szczególnie w meteorologii i klimatologii.

[1] https://raspstephan.github.io/blog/weatherbench

[2] https://doi.org/10.1175/JHM-D-14-0124.1

[3] https://doi.org/10.1007/s00382-015-2836-2

[4] https://doi.org/10.1016/j.atmosres.2019.01.005

[5] https://www.researchgate.net/publication/311777819_Variability_of_atmospheric_circulation_in_Euro-Atlantic_region_1900-2012

[6] https://doi.org/10.1016/j.atmosres.2019.05.010

[7] https://raspstephan.github.io/blog/weatherbench/

[8] https://meetingorganizer.copernicus.org/EMS2018/EMS2018-309.pdf

[9] https://doi.org/10.3390/atmos9060203

[10] https://doi.org/10.1007/978-3-662-04956-3_59