Prognozowanie pogody przy użyciu modeli numerycznych stanowi jedno z najważniejszych osiągnięć nauki w zakresie krótko-, średnio- i długoterminowego przewidywania stanu atmosfery. Tak spektakularny postęp nie byłby jednak możliwy bez wysiłku społeczności badaczy, inżynierów i specjalistów technologii informatycznych, którzy przez niemal 100 lat dokonywali kluczowych odkryć i udoskonaleń. W ich gronie nie zabrakło pracowników polskich instytucji badawczo-rozwojowych, w tym ekspertów z Instytutu Meteorologii i Gospodarki Wodnej.

AUTOR: Jan Wacław Parfiniewicz, IMGW-PIB/Centrum Modelowania Meteorologicznego

Pierwszą numeryczną prognozę pogody (NPP) policzono przy użyciu – nowatorskiego w ówczesnym czasie – lampowego komputera ENIAC znajdującego się w Princeton University (USA), a jej twórcami byli J.G. Charney, R. Fjortoft i J. von Neumann (1950). Prognozę pola geopotencjału (wysokości powierzchni) 500 hPa na 24 godziny uzyskano z modelu ekwiwalentno-barotropowego równania wirowości. Teoretyczne podstawy modelu zostały wypracowane przez Charney’a w 1949 roku, a poprzedzone pracą C.G. Rosby’ego, która ukazała się w 1939 roku. Zastosowana metoda numeryczna (w tym analiza stabilności schematu różnicowego) była rezultatem częściowo utajnionych prac, prowadzonych w Los Alamos przez von Neumanna. Wpływ na pracę Rosby’ego mieli współcześni mu F. Exner i H. Ertel (1942), H. Philips (1939), E. Eady (1949, 1952), A. Eliassen (1949), J. Petterssen i J. Bjerknes (1904), twórca meteorologii synoptycznej i teorii rozwoju frontów atmosferycznych).

Za fundament NPP, jak również meteorologii dynamicznej uznaje się pracę V. Bjerknesa z 1904 roku, w której prognoza pogody została sformułowana jako zagadnienie początkowo-brzegowe na gruncie fizyki matematycznej (zagadnienie Cauchy’ego). Z kolei prace von Neumanna w zakresie metod numerycznych były poprzedzone fundamentalnymi dziełami H. Philippsa i N. Wienera (1923), R. Couranta, K.O. Friedrichsa i H. Lewy’ego (1928), a także L.F. Richardsona (1911, 1922, 1926). Wielkim przegranym w tym wyścigu był Richardson, twórca podstaw analizy schematów różnicowych dla równań różniczkowych z pochodnymi cząstkowymi, który jako pierwszy za pomocą ręcznych kalkulatorów obliczył prognozę pola ciśnienia. Obarczony grubym błędem wynik spowodował, że jego heroiczny wysiłek został przez współczesnych mu meteorologów zlekceważony.

Rozwój NPP od lat 50. W działalności związanej z numerycznymi prognozami pogody, prowadzonej od drugiej połowy XX wieku, można umownie wydzielić trzy główne fazy. Okres 1950-1965 to etap stosunkowo słabych komputerów o egzotycznych nazwach: ENIAC, BESK, BESM, później IBM, Strela, Mark II, a także modeli limitowanych liczbą poziomów i założeniami quasi-geostroficzności i adiabatyczności (bez przemian pary wodnej). Dekada liczona od 1965 do 1975 roku charakteryzowała się rozwojem mocy obliczeniowych i powstaniem dużych ośrodków prognostycznych: w Waszyngtonie, Bracknell, Offenbach, Moskwie, Tokio, Melbourne. W tym czasie powołano również Europejskie Centrum Średnioterminowych Prognoz Pogody (ECMWF). Nastąpiło przejście na pełny (tzw. prymitywny) układ równań (Shuman 1960; Hinkelman 1965), aplikacje do teorii klimatu i stopniowe uwzględnienie przemian fazowych (mikrofizyki). Rozwijały się metody obiektywnej automatycznej kontroli i analizy coraz większej ilości informacji, w tym obserwacji satelitarnych. W 1975 roku zaczęła się era superkomputerów. Intensywny rozwój metod numerycznych i technik asymilacji danych, w tym złożonych metod wariacyjnych, doprowadził do powstania kilkudziesięciopoziomowych modeli globalnych i lokalnych (Limited Area Model, LAM) z pełną fizyką. W pracach wykorzystywano radary i rozwiązywanie zadań odwrotnych. Powstało centrum w Tuluzie, a na znaczeniu stracił ośrodek w Moskwie. Negatywnym zjawiskiem była postępująca koncentracja potencjału technicznego i intelektualnego, komercjalizacja NPP i konkurencja hamująca swobodną wymianę myśli twórczej.

Przyczynek do rozwoju NPP w IMGW

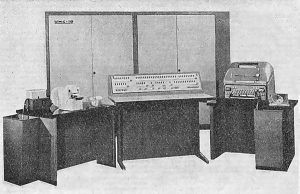

Epoka Wirtha, 1963-1978. Zygmunt Wirth, absolwent Uniwersytetu Warszawskiego, jako pierwszy w Polsce rozpoczął w 1963 roku eksperymenty NPP. Wzorując się na pracy J.G. Charneya (1949) i G.P. Cressmana (1959), pod patronatem Feliksa Wirkusa (który zaadaptował do prognozy pola geopotencjału 700 hPa metodę graficzną), uruchamiał offline model barotropowy na pierwszych w Polsce „egzotycznych” komputerach – Ural-2, lampowym kolosie należącym do PAN i zajmującym pół piętra Pałacu Kultury i Nauki, a także maszynie Elliot w Międzylesiu z pamięcią taśmową, karuzelowo-wahadłową. Następnie we współpracy z E. Maron i A. Misiukiewicz przeniósł model na drugi komputer IMGW UMC-10 (pierwszy, UMC-1, nie nadawał się do liczenia), potem na Odrę 1204 i Odrę 1305.

Wyniki modelu były lepsze od 24-godzinnej prognozy wykonanej metodą graficzną i od 1970 roku model uruchamiano operacyjnie raz dziennie. Dane były odczytywane z map synoptycznych. Domena modelu obejmowała na zachodzie znaczną część Atlantyku, na wschodzie sięgała po Ural. Równolegle prowadzono prace badawcze nad neutralizacją ujemnego wpływu warunków brzegowych. Programy początkowo były pisane w językach wewnętrznych (W-20), następnie w ALGOL-u, ostatecznie w Fortranie. W tym czasie zaczął też funkcjonować program WWW, który w ramach struktur WMO pozwalał podwiązywać modele NCM-ów do modeli ośrodków regionalnych.

Ambicją Wirtha, jako szefa ETO, było scentralizowanie zarządzania infrastrukturą obliczeniową IMGW, połączenie komputera typu mainframe z węzłem łączności IMGW i wdrożenie ruchu całodobowego pod kątem NPP. W tej koncepcji informatyka, będąc narzędziem, miała spinać działalność merytoryczną całego IMGW. Wirth zgromadził wokół siebie grupę wysoko wykwalifikowanych programistów i informatyków, obok wspomnianych Maron i Misiukiewicz pracowali u niego m.in. W. Czernuszenko, T. Sobczyk, J. Czechowicz i B. Jakubiak. Do zespołu dołączył wkrótce J. Karpiński, twórca mikrokomputerów ZAM i MOMIK, który razem z Sobczykiem miał się zająć komputeryzacją łączności dalekopisowej (wspólnie z niezapomnianym cichociemnym Henrykiem Ostrowińskim).

Strukturę ETO tworzyły komórki informatyczne obsługujące prognozy (meteorologiczne krótko- i długoterminowe, prognozy agro- i hydrologiczne), grupa teleinformatyki, grupa roczników i eksploatacja. Całości patronował S. Reinchart. Od 1975 roku zespół napotykał poważne problemy w realizacji założeń Wirtha – począwszy od metodyki interpretacji synoptycznej NPP, poprzez uwarunkowania polityczne utrudniające kontakt z Zachodem, skończywszy na odejściu pracowników ETO do zakładów merytorycznych i widmie totalnej komputeryzacji systemami typu PC. Ostatecznie bezpośrednią przyczyną upadku idei scentralizowanych komputerów z wielodostępem typu mainframe (horse computer) był konflikt Wirtha z operatorami Odry odmawiającymi pracy nocą.

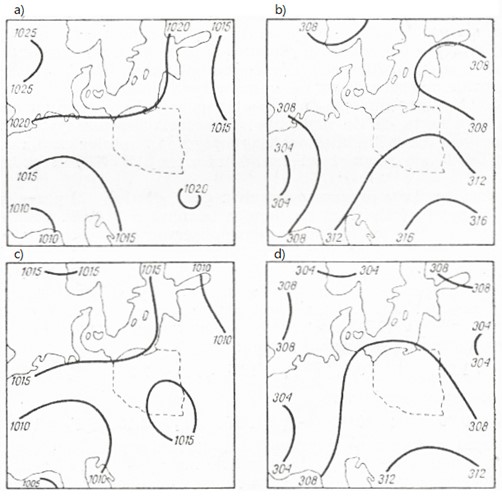

Epoka Predictu, 1975-1985. Koncepcja w pełni zautomatyzowanego systemu NPP zaimplementowanego na Odrze 1305 była ściśle uzależniona od dwuparametrycznego modelu baroklinowego Iljina-Ruchovca, udostępnionego przez rosyjski zespół z Petersburga. Wstępne przetwarzanie taśm dalekopisowych opracowali współpracownicy T. Sobczyka (E. Sosnowska i W. Piętak). Metodę tzw. kompleksowej kontroli danych stworzył J. Parfiniewicz (1975) pod kierunkiem L.S. Gandina, a do obiektywnej analizy zaadaptowano metodę optymalnej interpolacji (OI, Gandin 1963). W zespole programistów, będących jednocześnie pracownikami merytorycznymi, znaleźli się również B. Jakubiak i W. Sławiński.

Efektowne osiągnięcia informatyczne stopniowo ujawniały braki logistyczne. Był to okres, w którym rosyjska technologia zaczęła odstawać od zachodniej. Braki techniczne nadrabiano sofistycznymi koncepcjami, tworząc m.in. skomplikowane schematy NPP, co było możliwe dzięki świetnie przygotowanej merytorycznie kadrze naukowej zakotwiczonej jeszcze w dorobku Akademii Petersburskiej (Gandin uczeń Yudina, Yudin – Kibela, Kibel – Fridmana, Fridman – Czapłygina, Czapłygin – Żukowskiego, który z kolei czerpał od Eulera i Bernoulliego sprowadzonych do Rosji jeszcze przez Piotra I). O poziomie rosyjskich badaczy świadczy to, że znaczna ich część wyemigrowała w latach 80. na Zachód, gdzie zajmowali liczące się pozycje w środowisku naukowym.

O ile prace poświęcone doskonaleniu modelu małoparametrycznego (które autor prowadził razem z L.V. Ruchovcem, 1977-1981) mają dziś ograniczone znaczenie praktyczne, o tyle przedstawione ówcześnie rozwiązania związane z kontrolą danych (1973-1981) pozostają aktualne (koncepcje Lorentza (1990) z założeniem apriorycznej wiedzy o zachowaniu się grubych błędów są dyskusyjne), a zapoznanie się z technologią OI pozwoliło na ich twórczą aplikację (1983-1998). Na zagrożenia wynikające z uzależnienia się od rosyjskiej myśli technicznej wskazywał K. Haman. Zaniechanie koncepcji Wirtha, niższa od niemieckich i angielskich jakość prognoz i nadejście epoki PC spowodowały zarzucenie projektu Predict i wstrzymanie rozwoju NPP w IMGW.

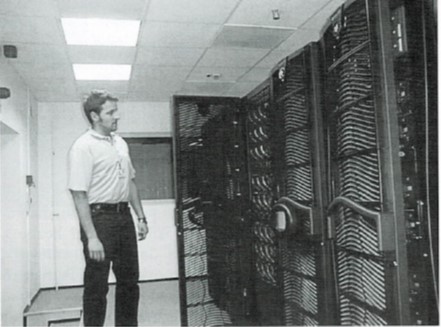

Rozwój po 1985. Euforia związana z dostępem do komputerów typu PC zaowocowała w IMGW rozwojem automatycznych systemów przetwarzania informacji meteorologicznej. Grupa T.S. (późniejszy T&S) stworzyła system wspomagania synoptyka (SWS), a S. Kozłowski i P. Ignatowicz uruchomili system POGODA. W obu narzędziach wykorzystano elementy kontroli i analizy wypracowane w projekcie Predict. W ramach współpracy z WMO natomiast powstały systemy MSDAD i SVARD (1987-1991), w których główny nacisk położono na wizualizację pól skalarnych i wektorowych, co pozwalało opracowywać oryginalne algorytmy obliczania izolinii i linii prądu. W 1994 roku zespół w składzie: A. Kadłubowski, L. Herman-Iżycki, M. Lazanowicz i A. Chmielewski wdrożył RADMET – narzędzie do interpretacji wielkoskalowych prognoz dostępnych via GTS. Początkowo RADMET cieszył się sporą popularnością jako system adresowany bezpośrednio do użytkownika z pominięciem synoptyków. Jednak z chwilą uruchomienia superkomputera CRAY w ICM UW i uzyskania możliwości aplikacji na nim modelu LAM UKMO z pracy nad systemem RADMET zrezygnował L. Herman-Iżycki, który wraz z B. Jakubiakiem przeszedł do ICM. Z kolei A. Kadłubowski realizował się w modelu hydrologicznym opartym na zasadzie de Saint-Venanta. W tym czasie J. Parfiniewicz poświęcał się rozwojowi metodyki asymilacji danych radarowych (1996-1998), jak również aplikacji koncepcji wirowości potencjalnej do analizy i diagnozy szczególnie intensywnych procesów meteorologicznych (których od czasu wichury i powodzi 1997 roku nie brakowało). Tymczasem w Krakowie zespół pod kierunkiem M. Jerczyńskiego uruchomił francuski model LAM (ARPEGE/ALADIN). W ramach koncepcji projektu SMOK planowana była implementacja modelu niehydrostatycznego nowej generacji, który został pozyskany z DWD (LM).

W tym czasie zaplecze środowiskowe prac prowadzonych w IMGW stanowiły instytuty naukowe: IGF UW, IGF PAN i IIS PW. Należy odnotować w tym kontekście sukcesy na arenie międzynarodowej, odniesione m.in. przez P. Smolarkiewicza (metody numeryczne), P. Flataua (radiacja), Z. Sorbjana, L. Łobockiego (warstwa graniczna), M. Uliasza, P. Bartnickiego (dyfuzja zanieczyszczeń) i W. Grabowskiego (mikrofizyka, modele klimatu). Prowadzone w IGF UW seminaria środowiskowe pod kierunkiem K. Hamana i z udziałem J. Borkowskiego niewątpliwie miały wpływ na podniesienie poziomu prac prowadzonych w IMGW.

Tekst powstał dzięki inicjatywie i wsparciu merytorycznemu i edytorskiemu dra hab. Andrzeja Wyszogrodzkiego, za co serdecznie mu dziękuję.

Oprac. Jan Wacław Parfiniewicz | Centrum Modelowania Meteorologicznego, IMGW-PIB.

Zdjęcie główne: Brandon Morgan | Unsplash.