Centra danych, a przede wszystkim umieszczane w nich superkomputery, odgrywają w nauce i gospodarce kluczową rolę. Wykorzystywane technologie obliczeniowe umożliwiają bowiem uruchamianie coraz bardziej skomplikowanych symulacji numerycznych, które modelują zjawiska od mikrokosmosu do makrokosmosu, procesy technologiczne, ekonomiczne i socjologiczne. Coraz doskonalsze superkomputery z roku na rok są wydajniejsze i oferują narzędzia oraz systemy wspomagające symulacje zachęcające do korzystania z nowoczesnych rozwiązań badawczych. Ten skokowy i imponujący wzrost wydajności i powszechności infrastruktury informatycznej wiąże się jednak z ze zwiększoną emisją gazów cieplarnianych i określonym, niestety negatywnym, wpływem na środowisko. Można uznać za swoisty paradoks, że aby na przykład zrozumieć mechanizmy globalnego ocieplenia i móc analizować scenariusze klimatyczne, zmuszeni jesteśmy sięgnąć do technologii, które te negatywne zmiany pogłębiają. Pocieszające jest, że największe firmy z branży IT i centra badawcze dostrzegają problem i poszukują nowatorskich rozwiązań pozwalających zmniejszać ślad węglowy superkomputerów i serwerów przechowujących rosnącą nieustannie ilość danych.

AUTORZY:

Mariusz Figurski, IMGW-PIB

Rafał Stepnowski, IMGW-PIB

Jerzy Proficz,Centrum Informatyczne Trójmiejskiej Akademickiej Sieci Komputerowej

Według raportu opublikowanego przez francuski think-tank The Shift Project, w marcu 2021 roku emisje dwutlenku węgla z infrastruktury technologicznej i serwerów danych, które umożliwiają przetwarzanie w chmurze, były wyższe od wielkości emitowanych przed pandemią Covid-19 przez cały transport lotnictwa cywilnego. W ostatnich latach rośnie presja na dostawców usług IT, w tym również szeroko rozumianych usług meteorologicznych, aby ich działalność była bardziej przyjazna dla środowiska. W wielu krajach Unii Europejskiej przyjęto ambitne plany redukcji emisji gazów cieplarnianych do 2030 i 2050 roku[i], a to właśnie na starym kontynencie chętnie lokują swoje siedziby firmy, których centra danych tworzą tzw. chmurę – wirtualny świat, który w rzeczywistości jest fizycznym systemem łączącym Internet z ziemią, wymagającymi stałej dostawy energii elektrycznej. Dlatego najwięksi poszukują rozwiązań, w jaki sposób zmniejszyć zużycie energii i ograniczyć swój wpływ na środowisko.

Lokalizacja – im zimniej, tym lepiej

W szeregu niskich, niepozornych budynków biurowych na przedmieściach sześciotysięcznej miejscowości Njarðvík, położonej na zachodnim wybrzeżu Islandii, znajdują się centra danych dla wysokowydajnych obliczeń i symulacji komputerowych, należące do firmy Verne Global. Nie wiemy czy założycieli spółki urzekł surowy krajobraz wyspy, przypominający Ziemię sprzed setek tysięcy lat, czy też ich decyzja w 2012 roku była motywowana zamiłowaniem do Hàkarl. Niemniej dokonali trafnego wyboru, dzięki któremu Verne Global korzysta dziś z szybkich połączeń światłowodowych oraz taniej i prawie zeroemisyjnej energii geotermalnej, a ich serwery nie wymagają aż tak dużej ilości energii do chłodzenia.

Na Islandii swój superkomputer ma również Duński Instytut Meteorologiczny, a z usług Verne Global korzysta m.in. Meteo Expert, zajmująca się badaniami meteorologicznymi i klimatologicznymi. Coraz więcej klientów francuskiej firmy Atos, dostarczającej rozwiązania IT w obszarach usług konsultingowych i technologicznych, integracji systemów i outsourcingu procesów biznesowych, decyduje się przenieść swoje superkomputery do całkowicie ekologicznych centrów danych, ze względu na niskie koszty energii. Lokalizacja serwerów w krajach skandynawskich pozwoliła niektórym firmom zredukować emisję z ponad 11 milionów CO2 rocznie do zera. To oszczędność odpowiadająca zużyciu energii przez ponad 10 tys. gospodarstw domowych.

Alternatywne drogi

Firmy którym nie uśmiecha się wyprowadzka na daleką północ, a chcącym niwelować swój ślad węglowy – nie tyle ze względów etycznych, co ekonomicznych – pozostają inne, równie skuteczne rozwiązania. Chiński gigant Lenovo stosuje w swoich superkomputerach systemy chłodzone wodą, które umożliwiają usunięcie do 90 proc. ciepła wytwarzanego przez ich komponenty. Chłodzenie wodą pozwoliło na rezygnację z wentylatorów, które są największymi „pożeraczami” energii elektrycznej, a innowacyjny zamknięty system zwiększa wydajność całej technologii. Opracowane przez Lenovo rozwiązanie jest od 2018 roku dostępne na rynku komercyjnym.

Chłodzenie cieczą staje się popularne również w instytucjach publicznych, do dziś wdrożono je m.in. w Malezyjskim Departamencie Meteorologii, Biurze Meteorologicznym Prowincji Zhejiang, Instytucie Badań nad Wpływem Klimatu w Poczdamie czy centrum superkomputerowym SciNet Canada na Uniwersytecie w Toronto. Na początku 2021 roku wspomniany już francuski Atos podpisał z Europejskim Centrum Prognoz Średnioterminowych czteroletni kontrakt, o wartości ponad 80 mln euro, na dostawę BullSequana XH2000, jednego z najpotężniejszych superkomputerów meteorologicznych na świecie. Tu również ma być zastosowane chłodzenie cieczą DLC, które ma pozwolić obniżyć temperaturę systemu do 40 st. Celsjusza. Jak wyjaśniają przedstawiciele Atos, około 95% wytworzonego ciepła jest odprowadzane do wody, dzięki czemu systemy są niezwykle energooszczędne. Dodatkowo technologie Bull Energy Optimizer i Dynamic Power Optimizer dostarczają na bieżąco informacji na temat temperatury wszystkich komponentów superkomputera i kontrolują zużycie energii całego systemu, bez uszczerbku dla jakości pracy wszystkich aplikacji.

W Polsce pierwsze superkomputer chłodzony cieczą powstał w 2015 roku w Akademickim Centrum Komputerowym Cyfronet[ii] AGH – był to Prometheus, w tamtym czasie najpotężniejsza jednostka w naszym kraju (2.6 PFLOPS), wyprodukowana przez firmę HPE. Powstałe od tamtego czasu instalacje w większości przypadków wykorzystują technologię chłodzenia cieczą, włącznie z najmocniejszym obecnie (11.2021, 8 PFLOPS) superkomputerem Altair, wyprodukowanym przez firmę Huawei i zainstalowanym w Poznańskim Centrum Superkomputerowo-Sieciowym[iii] (PCSS) przy IChB PAN.

Badamy i zanieczyszczamy – pułapka bez wyjścia?

Superkomputery i klastry komputerowe to dziś podstawowe narzędzia badawcze naukowców, zajmujących się w szczególności bioinżynierią, fizyką cząstek elementarnych, astronomią i oczywiście modelowaniem pogody i klimatu. Niestety praca na tych niesamowicie wydajnych i potężnych urządzeniach wymaga dużej ilości energii, a tym samym przyczynia się do wzrostu emisji dwutlenku węgla do atmosfery. Środowisko naukowe jest świadome tego faktu i w ostatnich latach ukazało się kilka istotnych opracowań na ten temat.

Astronomia i dwutlenek węgla

Bardzo interesujące wnioski z badań nad wpływem nauki na klimat opisano w cyklu sześciu artykułów opublikowanych w magazynie Nature Astronomy. W jednym z nich zespół naukowców z Instytutu Astronomii im. Maxa Plancka w Heidelbergu przedstawił wyniki o ilości CO2 wyemitowanego w 2018 roku w wyniku ich działalności. Astronomowie odkryli, że dominującym czynnikiem tej emisji były loty międzykontynentalne na konferencje lub osobiste obserwacje prowadzone w odległych obserwatoriach Ameryki Północnej i Południowej oraz zużycie energii elektrycznej w obiektach superkomputerowych (astronomowie powszechnie korzystają z klastrów i superkomputerów w symulacjach fizycznych i analizie danych). Łącznie jeden tylko naukowiec przyczynił się do wyprodukowania średnio 18 ton dwutlenku węgla. Jego ślad węglowy był więc prawie dwukrotnie większy niż przeciętnego mieszkańca w Niemczech. Zalecenia? Drastyczne ograniczenie tzw. „lotów badawczych” i przeniesienie superkomputerów do miejsc, gdzie dostępna jest energia ze źródeł odnawialnych, a chłodzenie łatwiejsze i mniej kosztowe.

W artykułach poruszono również zagadnienie wpływu zmiany klimatu na badania astronomiczne. Analizie poddano jedno z najnowocześniejszych miejsc do obserwacji kosmicznych – obserwatorium Paranal Europejskiego Obserwatorium Południowego w Chile – dla którego dostępny jest kompletny zbiór danych meteorologicznych. Badania wykazały, że w ostatnich 40 latach zarejestrowano tam wzrost temperatury o 1,5 st. Celsjusza, czyli o około pół stopnia więcej niż wynosi średnia światowa. Rodzi to konkretne następstwa. Przy temperaturach powyżej 16 st. Celsjusza praktycznie niemożliwe jest całkowite schłodzenie teleskopów podczas otwierania kopuł o zachodzie Słońca (zabieg ten ma celu zredukowanie wewnętrznych turbulencji). Ocieplanie się klimatu oznacza, że coraz trudniej będzie uzyskać wysoką jakość zdjęć i uniknąć „rozmywania się” obserwacji. Ponadto ważną rolę w astronomii odgrywają zawirowania powietrza wpływające na przepływ światła i zawartość pary wodnej w troposferze. Z tego względu coraz częściej obserwatoria wynoszone są w przestrzeń kosmiczną (co ponownie wiąże się z emisją CO2 podczas startu rakiety!).

Lepsze prognozy? Mocniejsze komputery i więcej energii…

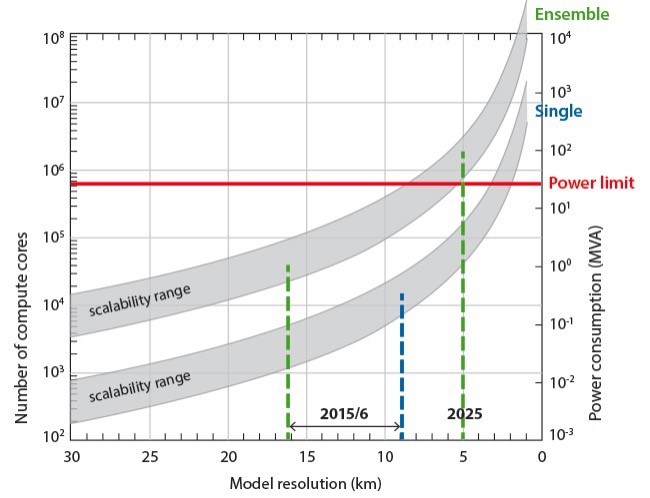

Podobny problem z wykorzystaniem superkomputerów i wynikającym z tego wzrostem śladu węglowego mają naukowcy zajmujący się modelowaniem pogody i klimatu. Postęp w numerycznym prognozowaniu pogody jest ściśle związany z rozwojem superkomputerów, których coraz większe moce obliczeniowe pozwalają nam uzyskiwać bardziej dokładne i szczegółowe wyniki. Jednak w miarę, jak systemy prognozowania stają się bardziej złożone, opracowywanie prognoz zgodnie z określonym harmonogramem i po rozsądnych kosztach, również tych środowiskowych, może się przy obecnych architekturach obliczeniowych wkrótce stać niemożliwe. Dlatego tak istotny jest rozwój sprzętu informatycznego – oczekuje się, że nowe generacje systemów superkomputerowych eksaskalowalnych, o większej wydajności energetycznej, pozwolą na ograniczenie emisji dwutlenku węgla. Jednocześnie przetwarzanie równoległe będzie odbywało się na poziomach, do których obecne kody numerycznych modeli pogody nie są przystosowane. Wynika z tego, że jeśli mamy wykorzystać nowe możliwości w zakresie efektywności energetycznej potrzebne są głębokie zmiany w całym łańcuchu przetwarzania danych w NMP.

Nad zagadnieniem tym od wielu już lat pracują duże organizacje meteorologiczne, czego przykładem jest „Program Skalowalności” uruchomiony przez ECMWF w 2013 roku. Jednym z najważniejszych celów projektu jest opracowanie przenośnych struktur kodów modeli, zapewniających dużą wydajność i czytelność kodu z uwzględnieniem technologii przyszłości oraz opracowanie metryk do testowania kodu, które pozwolą na ilościową ocenę skalowalności procesów. Program ma charakter interdyscyplinarny, dlatego uczestniczą w nim specjaliści od modelowania meteorologicznego, fizycy, matematycy, informatycy i dostawcy sprzętu komputerowego z całego świata. Ich zadaniem jest skoordynowane podejście do rozwoju sprzętu i oprogramowania, umożliwiające wykorzystanie nowoczesnych i innowacyjnych technologii.

Czy najlepszy superkomputer pogodowy na świecie będzie eko?

Brytyjska służba meteorologiczna Met Office poinformowała o podpisaniu dziesięcioletniego kontraktu z firmą Microsoft na dostawę jednego z najbardziej zaawansowanych na świecie superkomputerów do modelowania klimatu i pogody. Inwestycję dofinansuje rząd Wielkiej Brytanii kwotą 1,2 miliarda funtów, a wdrożenie ma obejmować nie tylko zakup technologii, ale także migrację danych i uruchomienie pakietu systemów na nowej maszynie. Według specjalistów superkomputer Met Office, po osiągnięciu pełnej wydajności, będzie dwa razy mocniejszy niż jakakolwiek tego typu jednostka w Wielkiej Brytanii.

W miarę ulepszania przez Met Office modeli prognozowania pogody, stają się one coraz większe i wymagają większej mocy obliczeniowej. Przez pierwsze pięć lat obowiązywania umowy nowy superkomputer zapewni sześciokrotnie większą moc obliczeniową niż maszyny, którymi obecnie dysponuje brytyjska służba meteorologiczna. „Dzięki temu wdrożeniu będziemy mogli uruchamiać znacznie większe modele, na wyższym poziomie szczegółowości”. – wyjaśnia Nic Bellingham, szef ds. technologii superkomputerowych w Met Office. – „Jednym z obszarów, które chcemy rozwijać są modele w skali miasta, uruchamiane na żądanie, pozwalające dokładniej przyjrzeć się takim zjawiskom pogodowym jak burze, mgły, fale upałów czy nawalne deszcze. To będą te same produkty, które dostarczamy dzisiaj, ale diametralnie zmieni się ich szczegółowość i szybkość pozyskiwania dzięki zmniejszeniu luki między punktami danych w modelu. Wyższa rozdzielczość oznacza, że możemy uwzględnić więcej lokalnych różnic, na przykład w geografii, budynkach i powierzchniach lądowych”.

Superkomputer Met Office będzie całkowicie zasilany energią odnawialną, co pozwoli brytyjskiej służbie na zmniejszenie emisji CO2 o 7415 ton już w pierwszym roku eksploatacji (w porównaniu z obecnymi rocznymi emisjami). Dzięki hostingowi w serwerowniach Microsoftu znacznie poprawi się również współczynnik PUE nowej jednostki. Power Usage Effectiveness został opracowany w 2007 roku do określania efektywności energetycznej w centrach danych, jako stosunku całkowitej energii dostarczanej do serwerowni do energii zużywanej przez sprzęt IT. Im wartość współczynnika PUE jest bliższa 1, tym mniej energii marnowanej jest na potrzeby zapewnienia odpowiednich warunków klimatycznych serwerowni oraz odpowiedniej infrastruktury (zasilanie, chłodzenie itp.). Szacuje się, że w przypadku superkomputera Met Office wartość współczynnika wyniesie 1,1. To dobra wiadomość dla brytyjskiej służby meteorologicznej, która planuje osiągnięcie zerowej emisji CO2 do 2030 roku.

Nowatorskie inwestycje w Polsce i Finlandii

Centrum Informatyczne Trójmiejskiej Akademickiej Sieci Komputerowej[iv] (CI TASK) na Politechnice Gdańskiej będzie jednym z najnowocześniejszych obiektów w Europie. Sercem inwestycji jest nowoczesna, wysoce bezpieczna serwerownia, podzielona na oddzielne komory, w której zostaną umieszczone m.in. superkomputery chłodzone cieczą. Budynek zasilany będzie prądem stałym (400V DC), co stanowi innowację na skalę europejską i umożliwi znaczne oszczędności w użyciu energii elektrycznej. Wytwarzana podczas obliczeń energia cieplna będzie odzyskiwana w celu ogrzewania całego budynku CI TASK, z możliwością podłączenia innych obiektów kampusu Politechniki Gdańskiej. Budowa jest realizowana w ramach projektu Centrum Kompetencji STOS (ang. Smart and Transdisciplinary knOwledge Services).

Źródło: https://stos.gda.pl/.

Innym przykładem budowy ekologicznego centrum obliczeniowego jest LUMI[v] (ang. Large Unified Modern Infrastructure) w Kajaani na północy Finlandii, powstające w ramach europejskiego projektu EuroHPC Joint Undertaking[vi]. Obiekt będzie wzniesiony na bazie istniejących zabudowań przemysłowych po zamkniętej wytwórni papieru i zasilany pobliską elektrownią wodną. W centrum stanie potężny superkomputer marki Cray (obecnie HPE), o mocy obliczeniowej 550 PFLOPS, chłodzony cieczą i oparty na procesorach i kartach akcelerowanych (GPU). Wybór technologii i rozwiązań infrastrukturalnych, a także zimny klimat północy mają sprzyjać niskiej emisyjności całego przedsięwzięcia.

Przechowywanie danych z wykorzystaniem DNA, czy to fantastyka?

Eksperci szacują, że do 2025 roku będziemy globalnie produkować dziennie 463 eksabajty danych, co odpowiada ponad 200 milionom płyt DVD. Przy takiej ilości danych, niejednokrotnie wrażliwych, istniejące systemy ich przechowywania mogą stać się zawodne i z pewnością będą konsumowały coraz więcej energii. Rozwiązaniem tego problemu, a jednocześnie alternatywą dla klasycznych dysków twardych, jest przechowywanie danych w strukturach DNA. Pomysł by do „data storage” zaprząc DNA powstał kilkanaście lat temu. Technologia obecnie jest w fazie badań, ale jeśli uda się ją skomercjalizować z pewnością zrewolucjonizuje wiele sektorów gospodarki.

Obecnie istniejące rozwiązania zapisu danych cyfrowych w strukturach DNA są bardzo skomplikowane i wymagają złożonych procesów, które wiążą informacje z sekwencjami DNA, a dodatkowo są niezwykle energochłonne. Do zapisania danych cyfrowych niezbędne jest modyfikacja konkretnych białek, która zajmuje wiele godzin. Naukowcom z Northwestern University udało się przyspieszyć ten proces. Opracowali oni uproszczony system wykorzystujący pojedynczy enzym, terminalną transferazę deoksynukleotydylową (TdT), do transdukcji sygnałów środowiskowych do DNA. W proponowanej metodzie, nazwanej w skrócie skrócie TURTLES[vii] (Time-sensitive Untemplated Recording using Tdt for Local Environmental Signals) zrezygnowano z kopiowania istniejącej nici DNA i zastąpiono ją syntetyczną, co pozwoliło na zdecydowane przyśpieszenie zapisu (do zaledwie kilku minut) i zmniejszenie ilości energii potrzebnej do przeprowadzenia tego procesu. Rozwiązanie rodem z fantastyki naukowej, ale być może za kilka lat tego typu narzędzia będą powszechne i będziemy mogli przechowywać praktycznie nieograniczone ilości danych – i to bez generowania śladu węglowego.

Eksperci wskazują, że w najbliższej przyszłości centra danych coraz częściej będą lokalizowane poza tradycyjnymi rynkami FLAP (Frankfurt, Londyn, Amsterdam, Paryż). Jednym z najpopularniejszych kierunków są kraje skandynawskie, które oferują naturalne chłodzenie i niższy ślad węglowy. Ulepszona łączność dzięki nowym kablom podmorskim, takim jak kabel IRIS z Islandii do Irlandii, sprawi, że ekologiczne przetwarzanie danych stanie się jeszcze bardziej dostępne. Jednocześnie szacuje się, że do przyszłego roku jednostki centralne zużyją o 175 proc. więcej energii niż w 2014 roku. Wdrażanie alternatywnych źródeł energii i metod chłodzenia staje się więc priorytetem, zwłaszcza w obliczu rosnącego zainteresowania przedsiębiorstw i organizacji badawczych sztuczną inteligencją oraz symulacjami numerycznymi. Niezależnie od tego, czy nacisk kładziony jest na optymalizację wydajności komputera, zmniejszenie zapotrzebowania na chłodzenie, czy nawet przejście na czystsze źródła energii, jasne jest, że środowisko i klimat stają się głównym zagadnieniem w rozwoju nowoczesnej infrastruktury teleinformatycznej i HPC.

[i] https://www.consilium.europa.eu/en/policies/green-deal/eu-plan-for-a-green-transition/

[ii] https://www.cyfronet.pl

[iii] https://www.pcss.pl

[iv] https://task.gda.pl

[v] https://lumi-supercomputer.eu

[vi] https://eurohpc-ju.europa.eu

[vii] https://pubs.acs.org/doi/10.1021/jacs.1c07331

Na temat wzajemnych oddziaływań między astronomią a antropogeniczną zmianą klimatu możecie przeczytać również na łamach magazynu Urania https://www.urania.edu.pl/wiadomosci/astronomowie-ocenili-wplyw-kryzysu-klimatycznego-na-astronomie-i-wplyw-astronomii-na

Zdjęcie główne: Boris Bobrov | Unsplash

PROF. DR HAB. INŻ. MARIUSZ JÓZEF FIGURSKI. Dyrektor Centrum Modelowania Meteorologicznego IMGW-PIB i profesor Politechniki Gdańskiej. Specjalista w zakresie geodezji satelitarnej, meteorologii GNSS, technologii satelitarnych i numerycznego modelowania pogody. Ekspert w grupie parlamentarnej ds. przestrzeni kosmicznej. Autor nowej koncepcji prowadzenia badań w ramach otwartych zespołów naukowych „open team”.

RAFAŁ STEPNOWSKI. Hydrolog. Autor publikacji na temat zmiany klimatu, bioróżnorodności i zagadnień środowiskowych. Redaktor naczelny magazynu drukowanego „Obserwator” i magazynu online pod tym samym tytułem. Szef redakcji magazynu naukowego „MHWM”. W Instytucie pracuje od 2008 roku. Przez pierwszą dekadę był koordynatorem wydawnictw. Obecnie odpowiada za cały content pisany w IMGW-PIB.

DR INŻ. JERZY PROFICZ. Wicedyrektor Centrum Informatycznego Trójmiejskiej Akademickiej Sieci Komputerowej (CI TASK) na Politechnice Gdańskiej. Uzyskał stopień naukowy doktora (2012 r.) w specjalności Informatyka na temat przetwarzania strumieni danych w środowisku superkomputera (HPC, Big Data). Autor i współautor ponad 40 artykułów w czasopismach i na konferencjach naukowych związanych głównie z równoległym przetwarzaniem danych na komputerach dużej mocy (HPC, green computing, chmura obliczeniowa). Posiada 10-cioletnie doświadczenie w pracy w środowisku biznesowym, na stanowiskach kierownika zespołu, programista, deweloper i projektant systemów informatycznych dla polskich i międzynarodowych firm.